Künstliche Intelligenz (KI) für alle?

Mithilfe von Technik wollen wir uns das Leben vereinfachen. So unterstützt IT seit Jahren und mit zunehmender Durchdringung unser Wirtschaften und unseren Alltag. Wir können mit ihrer Hilfe sogar Dinge tun, von denen wir wenig bis keine Ahnung haben, bei mir z. B. die Steuererklärung. IT erweitert so scheinbar unser Kompetenzspektrum und erscheint uns als verlässlicher Partner.

Mit Künstlicher Intelligenz (KI) gehen wir den nächsten, irgendwie auch konsequenten Schritt: KI erweitert unseren Handlungs- und Entscheidungsraum. Sie kann viel mehr und viel schneller Informationen verarbeiten als wir Menschen, sie hat weltweit verfügbares Wissen im Zugriff und kann sogar dazulernen. Nicht verwunderlich, dass uns KI als etwas erscheint, das wir uns lange gewünscht haben. Mit ihren Möglichkeiten kann sie uns Dinge abnehmen, die uns überfordern oder einfach keinen Spaß machen, Schulaufsätze sind nur ein sehr triviales, aber gerne angeführtes Beispiel, Marketing-Texte ein weiteres – beides wird kontrovers diskutiert.

Gerade im professionellen Umfeld verspricht KI Abhilfe für essenzielle Probleme unserer Zeit: Den Fachkräftemangel, bürokratisch überfrachtete Abläufe und sogar Entscheidungsfindung, die bei zunehmender Komplexität rational immer schwieriger wird. Aber schaffen wir uns damit eigentlich nicht „nur“ eine Lösung für selbst geschaffene Probleme? Und – frei nach Einstein – das mithilfe einer Lösung, die auf einer ähnlichen Denkweise beruht wie die, die unsere Probleme erst geschaffen hat? Der klare Vorteil dabei wäre immerhin, wir können (erst einmal) wie gewohnt weitermachen, für unser auf Energieersparnis ausgelegtes Gehirn eine durchaus reizvolle Idee.

Künstliche Intelligenz – gar nicht so neu und doch neu

Die Nutzung von KI und die Diskussion darum ist natürlich nicht neu. KI-Forschung und -Anwendung gab es bereits während meiner Studienzeit in den 80-er Jahren als eigene Disziplin in Fachbereich Informatik der TU Berlin. Und sogar schon zu Zeiten meiner Kindheit gab es kritische Stimmen aus Expertenkreisen: So warnte Joseph Weizenbaum nach einschlägigen Erfahrungen mit einer Psycho-Software namens Eliza vor den Folgen von KI auf den Menschen. Aufgrund solcher und anderer Erfahrungen wurde dann in den 80-er Jahren auch folgerichtig das Fachgebiet „Computer und Gesellschaft“ an der TU Berlin eingeführt. KI-Systeme sind deshalb natürlich nicht verschwunden, sie wurden weiterentwickelt und unterstützen heute z. B. Mediziner bei Diagnosen. Eine durchaus wertvolle Errungenschaft.

Eine neue Qualität entsteht aktuell dadurch, dass KI nun offensichtlich als massentaugliches Produkt vermarktet und auch angenommen wird. Und in Unternehmen wird die Idee verfolgt, KI flächendeckend dort einzusetzen, wo menschliches Know-how fehlt, sei es, weil Fachkräfte fehlen oder sei es, dass der Mensch eben ganz einfach nicht über den Informationsspeicher der KI und deren Verarbeitungsmöglichkeiten verfügt. Unser Verstand nimmt an, dass wir durch ein Mehr an Wissen eben auch ein Mehr an Gewissheit erlangen, ein uralter Glaubenssatz industrieller Realität1.

Lebendige Umwelt

Nun ist es trivialerweise ja so, dass unsere Umwelt ziemlich lebendig ist, sich sekündlich (also eigentlich noch schneller) verändert. So entstehen neue Impulse und neue Chancen2. Vieles davon kriegen wir in unseren Smart Homes und an unseren Smartphones gar nicht mehr mit, denn die Technik um uns herum schafft eine völlig neue Atmosphäre, in der die sog. Weak Signals3, die uns auf solche Entwicklungen hinweisen, zunehmend schwieriger wahrzunehmen sind. Wir trainieren die dafür notwendigen Kompetenzen solcher Wahrnehmung nicht mehr, und die ständige Reizüberflutung macht deren Wahrnehmung im Alltag quasi unmöglich.

Es erscheint mir kein Zufall, dass KI gerade in einer Zeit in den Fokus der allgemeinen Öffentlichkeit rückt, die in unseren Augen durch Ereignisse geprägt ist, die nicht erwartbar waren. Corona, Kriege, Klimawandel machen Angst, weil wir offensichtlich nicht mehr alles in Kontrolle haben. KI wird durch ihr Mehr an Wissen, Ihre Möglichkeiten zur Vorhersage von wahrscheinlichen Szenarien und ihre Gestaltungsräume zum Hoffnungsträger, dass wir unsere immer schneller und komplexer werdende Welt mit ihrer Hilfe doch in Kontrolle haben können. Mehr Daten, mehr Geschwindigkeit und eine kognitive Intelligenz sollen dabei helfen, Ungewissheit endlich „in den Griff zu bekommen“. Und wie das so oft ist, wenn wir das Pendel in eine Richtung zerren, es entsteht sichtbar eine heftige Gegenbewegung. Bei KI zeigt sie sich schon jetzt sehr offensichtlich in Form von Fake-News und anderen Täuschungen, alles andere also als Gewissheit.

Das ist unangenehm, aber wohl noch handelbar mittels weiterer Technologie – und genau das wird auch diskutiert und umgesetzt. Problematischer und auch Risiko behafteter ist die zutiefst mit KI verbundene Hoffnung auf Kontrolle und Beherrschung der zunehmend komplexer und schneller werdenden Welt, in der wir leben. Bei aller Hoffnung wird jedoch häufig übersehen, dass Technik selbst ein Quell von Ungewissheit ist4. Das wird durch KI mit ihrer zunehmenden Komplexität und Lernfähigkeit eine neue Dimension erreichen.

KI aus Sicht der Ungewissheitsforschung

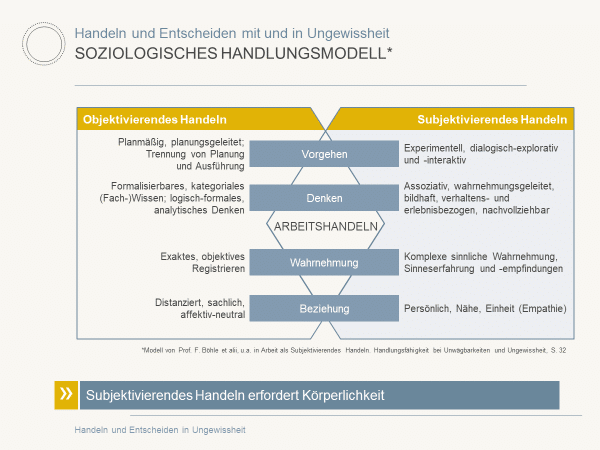

Für die Hoffnung, mittels KI Ungewissheit zumindest besser zu kontrollieren und durch ein Mehr an Wissen und Entscheidungsgeschwindigkeit mehr Gewissheit zu haben und „richtige“ Entscheidungen zu treffen, lohnt ein Blick in die Wissenschaft und auf die dort publizierten Kompetenzen zum Umgang mit Ungewissheit. Hier an dieser Stelle möchte ich diese Kompetenzen nur kurz grafisch mittels des Handlungsmodells von Prof. Fritz Böhle et alii darstellen, sodass Sie nachfolgende Überlegungen leichter nachvollziehen können.

Auf der linken Seite des Modells (Objektivierendes Handeln), also im Rational Kognitiven, ist KI stark. Messbarkeit, logische Analysen, Fachwissen, affektive Neutralität sind eine große Stärke technischer Systeme, ja letztendlich werden sie dafür sogar geschaffen.

Soziologisches Handlungsmodell von Prof. F. Böhle et alii

Deutlich schlechter sieht es hingegen auf der rechten Seite (Subjektivierendes Handeln) aus, deren Bedeutung in Ungewissheit essenziell ist: Intuition und Gespür bilden den Teil unserer Intelligenz, die für Subjektivierendes Handeln zuständig ist – keine kognitive, sondern eine verkörperte und durchaus auch emotional besetzte Intelligenz. Was aber bedeutet diese rechte Seite für die Intelligenz von KI?

KI und subjektivierendes Handeln

KI kann natürlich unsere Wahrnehmung unterstützen, aber ein Mehr an Daten und Informationen führt nicht zwingend zu einer verbesserten Intuition, eher das Gegenteil ist der Fall5. Und um wie viel schwerer wird notwendiges Loslassen im Wandel6, wenn uns die KI dann auch noch all das Wissen bereitstellt, das wir längst und oft aus guten Gründen verdrängt haben?

Und können Sie sich eine KI vorstellen, der beim Blick auf die Jahresplanung eines Unternehmens „die Haare zu Berge stehen“ oder die beim Anblick des neuen Logos „fröstelt“? Solche verkörperten Reaktionen sind typische Beispiele für subjektivierende Wahrnehmung.

Natürlich kann KI inzwischen auch eloquent mit uns kommunizieren, mittels Sprechen und sogar Mimik. Aber ist das wirklich Nähe und Empathie (subjektivierende Beziehungsebene) oder ist es nicht vielmehr eine rational taktische Meisterleistung, eine kognitive Empathie, wie sie auch im Narzissmus beschrieben wird?

Und ja, (generierende) KI kann unsere Kreativität durch Vorgehensvorschläge oder Mustererkennung und Bildgenerierung unterstützen (subjektivierende Ebenen des Denkens und Vorgehens), aber lebendige Kreativität ist eben mehr als das, sie setzt unsere verkörperten Sinne, unsere Emotionalität, unser Gespür voraus.

Unter diesen Aspekten ist bereits die Nutzung des Begriffes „Intelligenz“ in KI zumindest infrage zu stellen.

Ist KI wenigstens massentauglich?

Um Qualität der von der KI gelieferten Ergebnisse zu bewerten, braucht es den Blick von Expert:innen, die über Erfahrungswissen im Fachthema und mit der KI verfügen. Expert:innen haben aufgrund ihrer Erfahrung und ihres fundierten Wissen dieses immer wieder erwähnte Gespür für hilfreiche Angebote der KI. Und Expert:innen erkennen Fakes, eben auch weil sie irgendwie spüren „da stimmt was nicht“ und dem nachgehen. Laien aber sind überfordert, die Qualität zu bewerten und tendieren so leicht dazu, der KI zu vertrauen, weil „sie ja so viel weiß und so toll mit mir kommuniziert“ – mache ich übrigens bei der anfangs erwähnten Steuererklärung genauso, weil ich keine Ahnung und damit keine Alternative habe.

Es hat gute Gründe, dass im von mir gerne als Beispiel angeführten Star Trek die KI-Systeme für die Triebwerkssteuerung in kritischen Fällen von den Experten (Scotty, Geordi la Forge) befragt werden und nicht direkt von Captain Kirk oder Captain Picard. Erstere haben aufgrund ihres fundamentalen Wissens ein Gespür dafür, was helfen könnte und vor allem eben auch, was auch nicht. Und schon heute merken wir, dass die Ergebnisse der KI „besser“ werden, wenn wir die „richtigen“ Fragen oder Nachfragen stellen, Fachexpertise ist dafür mehr als nur hilfreich.

Wenden wir dies auf moderne, massentaugliche KI-Systeme an, so fehlt uns dieses Gespür, wenn wir nicht selbst Expert:in im Themenbereich sind. Und das gilt nicht nur im Ungewissen, die Bewertung von Handlungsoptionen erfordert Expertise. Fehlt diese, besteht das Risiko, den Vorschlägen der KI blind zu folgen – und das ist dann das genaue Gegenteil von Kontrollgewinn, vielmehr geben wir stückchenweise die Kontrolle an die KI ab.

Welche Konsequenzen das hat, zeigt sehr plastisch eine andere Science-Fiction-Serie, nämlich Stargate. In Folge 5, Staffel 7 (Die Macht des Speichers) bewohnen Humanoide eine von einem Computer geschaffene, idyllische Lebensumgebung unterhalb einer Kuppel, die sie scheinbar gegen die feindliche Umwelt schützt. Doch der Raum der Menschen wird unbemerkt immer enger, Konsequenzen dieser zunehmenden Enge werden vom Computer kaschiert, die Menschen bemerken die Widersprüche und bedrohlichen Ungereimtheiten nicht einmal mehr. Diese Episode ist eine wundervolle Metapher für das, was passiert, wenn wir mangels Kompetenz und aus Furcht vor dem Ungewissen (im Beispiel die scheinbar feindliche Umwelt) Technik die Kontrolle übergeben, ohne selbst kompetent zu sein. Unser Handlungsraum wird immer enger, unsere Dissoziation immer perfekter, aus Angst, uns der Realität zu stellen.

Star Trek, Staffel 1 zeigt ähnliche Metaphern, in denen das scheinbare Glück der Sicherheit einen hohen Preis in Form von zunehmender Einschränkung menschlicher Kreativität und Entwicklung hat.

KI und Ethik

Eine weitere Diskussion um KI ist zur Frage der notwendigen Ethik von KI. Selbstständig handlungsfähige KI-Systeme müssen ggf. Folgen ihres Handelns abwägen. Impulse hierzu finden wir in der von mir so gerne als Verdeutlichung herangezogenen Science-Fiction, nämlich in der Kultserie Raumpatrouille Orion. In der Episode „Hüter des Gesetzes“ übernehmen kleine Schürf-Roboter die Herrschaft über die sie betreuenden Menschen, weil die Menschen aus ihrer Sicht gegen die vermittelte Ethik verstießen und sich gegenseitig verletzten.

Ein reales Beispiel sind selbstfahrende Systeme, die in Extremfällen zwischen dem Schutz des Fahrers versus dem Schutz anderer Verkehrsteilnehmer entscheiden müssen oder die abzuwägen haben, ob Katze oder Igel überfahren wird. Menschen haben hierfür eine Art inneren Kompass, der sozial erlernt, in Teilen aber auch angeboren ist. Neben den rational vernunftbasierten Aspekten spielen dabei auch Körperreaktionen und Affekte eine wesentliche Rolle.

Es braucht mehr als nur Regeln. Ich persönlich möchte mein Leben nicht in die Hand eines Systems übergeben, das ganz rational zwischen meinem Leben und dem eines anderen Verkehrsteilnehmers entscheidet. Solche Aufgaben an Technik zu delegieren, bietet für mich keine Sicherheit und widerspricht auch meinem Anspruch an eigenverantwortliches Handeln. Und diese Frage stellt sich nicht erst in 10 Jahren, sondern bereits heute, wenn es um automatisiertes Fahren im Straßenverkehr geht.

Die KI Data

Die Erzählung um die KI Data in Star Trek Next Generation ist ein Lehrstück darüber, welche Hürden eine KI überwinden muss, um menschliche Intelligenz zu entwickeln. Beginnend mit einer rein kognitiven Intelligenz und immerhin ausgestattet mit einem Körper, muss sich Data ethischen Fragen widmen, Emotionen und Empathie erarbeiten und künstlerische Kreativität erlernen. Und die herausforderndste Aufgabe ist die Begegnung und Auseinandersetzung mit seinem Schatten, der in Form seines „bösen“ Bruders Lore erscheint und Data in einen eigenen, inneren Konflikt stürzt.

Selbst von Datas Anfängen sind unsere aktuellen KI-Entwicklungen noch weit entfernt, aber sie haben schon heute Möglichkeiten, uns durch ihr Wissen, ihren Geschwindigkeitsvorteil und ihre Kommunikation (und damit scheinbare Beziehung) mit uns in unserer humanoiden Entwicklung zu beeinflussen – und zwar durchaus in einer Richtung, die wir weder erwarten noch in die wir wollen.

Ein zusammenfassender Blick auf Risiken

Ich bin Projektmanagerin. Im Folgenden stelle ich daher anhand von KI im Projektmanagement die bereits angedeuteten Risiken noch einmal ganz konkret und sortiert dar. Ich folge damit der alten Projektleiter-Regel: Wenn wir die Chancen nutzen wollen, müssen wir uns mit den Risiken auseinandersetzen. Die nun folgenden Aspekte lassen sich natürlich auch auf andere Professionen jenseits von Projektmanagement übertragen.

Qualität

KI kann Projektmenschen entlasten oder Aufgaben durchführen, die sonst „der Zeit zum Opfer gefallen wären“ (beliebtes IT-Beispiel Testen). Und gleichzeitig sehen wir an vielen Stellen in professionellen Umfeldern, dass gewonnene Zeit zu einer Erhöhung des Durchsatzes führen muss statt zu vertieftem Eindringen ins Thema oder mehr Achtsamkeit bei der Arbeit. Die erhoffte Stressreduktion findet nicht statt, ebenso wie die erhoffte Verbesserung der Ergebnisqualität.

Projektleiter:innen sind Expert:innen für die Durchführung von Projekten und damit für Handeln und Entscheiden in Projekten. Übernimmt die KI komplette Aufgaben im Projektmanagement, wie z. B. die Projektplanung, besteht das Risiko, dass wesentliche Teile der Expertise für das konkrete Projekt und die genutzte Methodik verloren gehen. Die aber sind Grundlage für kompetentes, professionelles Projektmanagement sowie die damit verbundene Ergebnisqualität. Und es wird auch die notwendige Expertise für die Steuerung der KI gefährdet, die Expert:Innen schaffen sich quasi selbst ab.

Bereits mit der aktuellen KI-Generation können aufgrund der Interfaces auch Menschen ohne Fachexpertise arbeiten. So kann leicht der Eindruck entstehen, dass Projektleitung durch KI ersetzt werden kann. In einem solchen Fall entfällt die notwendige Bewertung der KI-Ergebnisse, und die KI hat freie Handlungsspielräume. In letzter Konsequenz steuert dann die KI-Projekte und nicht mehr der (Projekt-)Mensch die KI.

Ungewissheitskompetenz

Wir brauchen Kompetenzen des subjektivierenden Handelns, um Projekte bis hin zu großen Transformationen mit all ihrem Unerwartbaren zu bestehen. Dafür müssen Projektmenschen über die notwendigen Kompetenzen verfügen, denn wie oben dargestellt ist KI hier mangelhaft aufgestellt und wird es auch auf absehbare Zeit bleiben.

- Projektmenschen sammeln durch Tun Erfahrungen. Erfahrungswissen ist eine wichtige Ungewissheitskompetenz, und zwar eine, die sich erfahrene Projektleiter oft unbewusst erarbeitet haben. Ich sehe durch die Nutzung von KI das Risiko, dass weniger Erfahrungen gesammelt werden und damit weniger (unbewusste) Ungewissheitskompetenz aufgebaut wird. Das gefährdet Projekterfolg und Transformationen.

- In den Disziplinen des Projektmanagements werden bis heute die Kompetenzen zum Umgang mit Ungewissheit unzureichend bis gar nicht trainiert oder gefördert und gleichzeitig führen wir mit KI eine neue Quelle von Ungewissheit ein (Technik ist laut ISF München eine wesentliche Quelle von Ungewissheit, bereits 2016 hatte die in etwa das Ausmaß der Ungewissheit, die durch den Menschen verursacht wird7). Auch das gefährdet Projekterfolg und Transformationen.

Es gibt es auch im Projektmanagement immer wieder die Idee, Wissen zu vermehren, mit dem Ziel, Ungewissheit in Projekten zu beherrschen oder sogar zu beseitigen. KI ist eine wundervolle Möglichkeit, diesen Weg weiter zu beschreiten – nur leider ist das eben vor allem ein Mehr-vom-Selben des Rationalen, ein weiter wie bisher. Und das hat uns als Gesellschaft in eine Situation geführt, die wir eben immer weniger „im Griff haben“, es uns aber weiterhin „vorgaukeln“.

Projektifizierung der Gesellschaft8

In absehbarer Zeit werden wir die Frage der Ethik durch KI klären müssen, gerade auch im Projektmanagement, das die Zukunft unserer Gesellschaft mitgestaltet. Und diese wird das, was wir in ihr verankern, sehr viel konsequenter umsetzen als der Mensch. Ich denke am Beispiel Triage oder eben auch Raumpatrouille Orion wird deutlich, dass hier große Risiken liegen, die uns sogar der Kontrolle der Technik berauben können.

Verlieren wir wirklich die Kontrolle, dann haben wir einen Homunkulus geschaffen. Wir werden zum Schöpfer einer „Intelligenz“, die eigene Wege geht. Darüber nachzudenken, was das bedeutet, sprengt den Umfang und Inhalt eines Blogartikels.

Innovationen in Form von Technologien werden von Menschen nicht nur nutzbringend eingesetzt, sondern immer wieder schaden sie auch dem Wohl von Menschen – manchmal mit Absicht, manchmal einfach wegen mangelndem Wissen über die Konsequenzen des Einsatzes. KI hat Möglichkeiten, die bisher kaum denkbar waren. Und schon der Schaden der deutlich einfacheren Innovationen der letzten 150 Jahre ist so hoch, dass wir ihn möglicherweise nicht mehr reparieren können.

Fazit

KI ist ein Attraktor und kann uns – angemessen eingesetzt – wertvolle Unterstützung liefern, ja sogar die eine oder andere neue Idee bringen. Sie kann uns Arbeit abnehmen, kann uns bei Entscheidungen unterstützen, und sie kann uns helfen, den Fachkräftemangel besser zu bewältigen. Und gleichzeitig ist sie nicht intelligent im humanoiden Sinne. Aber immer da, wo es um rationale Aspekte geht, kann sie wertvolle Unterstützung bieten.

Damit das gelingt, gehört KI weiterhin und ausschließlich in die Hand von Expert:innen. Sie müssen Maßnahmen ergreifen, wie sie ihr Fachwissen aktuell halten, denn KI ist nun einmal schnell und hat einen riesengroßen Wissensspeicher. Im Handumdrehen kann ein:e Expert:in zum Laien werden und damit die notwendige Kontrolle über die Technik verlieren, aus Bequemlichkeit, mangels Einsicht oder aus Zeitdruck. Im harmlosen Fall werden damit die Chancen der KI-Nutzung zunichtegemacht.

Und damit schließt sich der Kreis: KI ist nicht massentauglich – außer vielleicht, um Gewinn zu machen. Ihre Risiken steigen bei unbedarfter Nutzung und ihre Chancen kommen nicht zum Tragen. Und vielleicht sollten wir ihr auch im Sinne besseren Erwartungsmanagements einen anderen Namen geben.

Extra-Bonus

Hier finden Sie 3 zusätzliche Fragen zu KI, die Astrid Kuhlmey beantwortet (bitte auf Plus drücken):

Wie fair ist es, einer KI mangelnde Intuition vorzuwerfen?

Astrid Kuhlmey: Meiner Meinung nach geht es nicht um Vorwürfe oder Fairness. Die Frage ist eher, wofür KI designt wird, was sie leisten kann und was sie nicht leisten kann.

Mit dem Begriff Intelligenz verbinden die meisten von uns unbewusst humanoide Intelligenz – gerade letztens sprach ein Kollege in einem LinkedIn-Kommentar von „KI als einem weiteren Kollegen“. Im Artikel versuche ich zu verdeutlichen, dass KI eben nicht über humanoide Intelligenz verfügt und gleichzeitig im kognitiv-rationalen Anteil deutlich schneller ist und besser mit vielen Informationen umgehen kann als ein Mensch.

Die Ungewissheitsforschung hat herausgearbeitet, dass eben dieser andere Anteil unserer Intelligenz, den eine Technik nicht hat (ich nenne ihn hier mal der intuitive) ganz wesentlich ist, um zu handeln und zu entscheiden. Das zeigt sich besonders deutlich, in Situationen der Ungewissheit (s. Böhle) ist aber auch im Alltag beobachtbar (s. Gigerenzer).

Nach meiner Beobachtung belächeln Organisationen das Thema “Intuition” oft. Das ist Teil der industriellen Gewissheitskultur, die das Denken in unserem Kulturkreis derzeit leider noch sehr stark bestimmt. Daher verwundert es auch nicht , dass wir KI mit dem Begriff Intelligenz belegen, sie mit Kollegen vergleichen oder ihr etwas vorwerfen können, was vielleicht nicht fair ist. 😉

Woher nimmst Du die Hoffnung, dass sich der Einsatz von KI durch einen gesellschaftlichen Diskurs in allgemein wünschenswerte Richtungen steuern lässt?

Astrid Kuhlmey: Auf der einen Seite bin ich optimistisch, denn wir haben im vorigen Jahrhundert als Menschheit schon einmal vor ähnlichen und herausfordernden Fragestellungen wie den aktuellen gestanden (Weizenbaum für KI, Ozonloch für Klimawandel). Beides haben wir gelöst. Meine Hoffnung basiert auf der wissenschaftlich untermauerten Annahme, dass der Mensch ein lernfähiges, spürendes Wesen ist und an Herausforderungen wächst – selbst wenn (oder gerade weil) wir uns die Steine erst einmal selbst in den Weg legen.

Auf der anderen Seite bin ich etwas pessimistisch, denn wir hatten bei den genannten Fragestellungen der Vergangenheit völlig andere gesellschaftliche, politische und individuelle Voraussetzungen mit durchaus anderen Werten. Da ich mich viel mit Geschichte beschäftige, sehe ich Parallelen zu Spätphasen anderer Hochkulturen.

Ich bewerte die aktuelle Situation mit einem mehr an Technologie und dafür weniger an echter Naturverbundenheit pragmatisch. Entweder bekommen noch die Kurve hin zu einer Kultur, die lebendiges Leben von Technik unterscheiden kann und die Wirtschaftlichkeit nicht über Lebendigkeit stellt, oder eben nicht. Das ist ein bisschen wie die Einstellung der Enterprise-Crew in Krisen: Wir meistern das oder eben nicht. Und eben nicht heißt, die Serie läuft ohne uns weiter. Das fände ich schade und gleichzeitig historisch nicht so neu.

Welche wirklichen neuen Anwendungsmöglichkeiten für KI könnte es geben?

Astrid Kuhlmey: In der derzeitigen Situation denke ich nicht darüber nach. Ich plädiere dafür, dass wir Experten sein müssen. Für etwas ganz Neues sind wir aber nicht Experten. Ich finde es nicht ungefährlich, noch ohne ausreichende Diskussion potentieller Nebenwirkungen etwas ganz Neues von einer Technik denken zu lassen, deren „Intelligenz“ durchaus narzisstische Aspekte hat.

Ich empfehle in der aktuellen Situation, dass wir aus der Nutzung technischer Möglichkeiten mal Geschwindigkeit herausnehmen, damit wir Menschen mithalten können. Wie wir durch den Klimawandel wissen, hatten die indigenen Völker nicht unrecht, als sie davor warnten, dass manches in der Industrialisierung etwas schnell ging. Und vielleicht ist das ein Fehler, der unsere westliche Kultur „auszeichnet“; wenn dem so ist, dann gilt https://t2informatik.de/blog/welcher-fehler-zeichnet-sie-aus/.

Hinweise:

[1] Prof. Fritz Böhle (2017), Subjektivierendes Handeln – Anstöße und Grundlagen, in Arbeit als Subjektivierendes Handeln, S. 3-32

[2] Expertise der GPM zum Umgang mit Ungewissheit in Projekten, 2016

[3] Unter Weak Signals werden in der Ungewissheitsforschung diffuse Signale für aufkommendes Geschehen verstanden, die körperlich wahrgenommen werden.

[4] Was wir von Raumschiff Enterprise lernen können

[5] Vgl. hierzu Gerd Gigerenzer, Bauchentscheidungen, Bertelsmann 2007

[6] Loslassen ist das neue Planen

[7] Vgl. die oben angeführte Expertise der GPM

[8] Mehr zur Relevanz der Projektifizierung und der damit verbundenen Bedeutung von Projektmanagement in der Gesellschaft finden Sie in Prof. Dr. Reinhard Wagner (2021), Projektifizierung der Gesellschaft in Deutschland

Wenn Ihnen der Beitrag gefällt oder Sie darüber diskutieren wollen, teilen Sie ihn gerne in Ihrem Netzwerk. Und falls Sie sich für weitere Tipps aus der Praxis interessieren, dann testen Sie gerne unseren wöchentlichen Newsletter mit neuen Beiträgen, Downloads, Empfehlungen und aktuellem Wissen. Vielleicht wird er auch Ihr Lieblings-Newsletter!

Astrid Kuhlmey hat weitere Beiträge im t2informatik Blog veröffentlicht, u. a.:

Astrid Kuhlmey

Dipl.Inf. Astrid Kuhlmey verfügt über mehr als 30 Jahre Erfahrung im Projekt- und Linienmanagement der Pharma-IT. Seit 7 Jahren ist sie als systemische Beraterin tätig und begleitet Unternehmen und Individuen in notwendigen Veränderungsprozessen. Ihr liegen Nachhaltigkeit sowie gesellschaftlicher und wirtschaftlicher Wandel und Entwicklung am Herzen. Gemeinsam mit einem Kollegen hat sie einen Ansatz entwickelt, Kompetenzen zum Handeln und Entscheiden in Situationen der Ungewissheit bzw. Komplexität zu fördern.

Im t2informatik Blog veröffentlichen wir Beträge für Menschen in Organisationen. Für diese Menschen entwickeln und modernisieren wir Software. Pragmatisch. ✔️ Persönlich. ✔️ Professionell. ✔️ Ein Klick hier und Sie erfahren mehr.