Wie gut sind KI-gestützte Code Reviews wirklich?

Ein Erfahrungsbericht über Code Reviews mit CodeRabbit, Greptile und GitHub Copilot

Code Reviews sind in der Entwicklung von Software unerlässlich. Sie helfen, Fehler früh zu finden, Codequalität hochzuhalten, Teamrichtlinien einzuhalten und Wissen zu teilen. So wichtig sie auch sind, Code Reviews kosten Zeit, können andere Arbeiten blockieren und sind nicht immer völlig objektiv. In stressigen Phasen werden sie auch mal nur oberflächlich durchgeführt.

Parallel dazu hat sich die KI in den letzten Jahren rasant entwickelt. Sprachmodelle können längst nicht nur Text, sondern auch komplexen Code „verstehen“ und generieren. Es überrascht daher wenig, dass sie inzwischen auch im Bereich der Code Reviews zum Einsatz kommen. Mittlerweile gibt es eine ganze Reihe von Tools, die Pull Requests analysieren und automatisches Feedback geben. Klingt praktisch, doch wie fühlt es sich in der Praxis an?

Eine Auswahl an KI-Tools und ein Projekt zum Testen

Die Auswahl an KI-Tools ist heute bereits riesig, und es ist gar nicht so einfach, sich für einen Anbieter zu entscheiden. Meine Wahl fällt auf CodeRabbit [1], Greptile [2] und GitHub Copilot [3]. Während CodeRabbit und Greptile auf Code Reviews spezialisiert sind, deckt Copilot weitere Aspekte des Programmierens ab.

Zum Testen dient ein kleines Full-Stack-Projekt: ein Expenses Tracker, in dem Nutzer sich registrieren und Ausgaben nach Kategorien erfassen können. Technisch besteht er aus einer Express API (TypeScript, Zod, Prisma, PostgreSQL) und einem Next.js-Frontend. Damit bleibt das Projekt handlich, bringt aber gleichzeitig genug Komplexität mit, um die Tools wirklich herauszufordern.

Alle Tools laufen mit ihren Standardeinstellungen auf derselben Codebasis. Für jedes Tool entstehen identische Pull Requests, sodass die Ergebnisse vergleichbar bleiben.

Wichtig ist mir: Das ist kein klassischer Vergleichstest mit Punktetabellen oder „Siegern“. Ich will herausfinden, wie gut KI-Reviews aktuell funktionieren, wo ihre Grenzen liegen und ob sich grundlegende Unterschiede zwischen den Tools zeigen.

Um die Tools stärker zu fordern, fließen bewusst kleine Fehler, Architekturänderungen und fehlende Anpassungen zwischen Frontend und Backend in die Pull Requests ein. So zeigt sich, wie zuverlässig die Tools Probleme erkennen, ob sie sinnvolle Verbesserungsvorschläge liefern und ob sie den Code auch im Gesamtkontext betrachten.

Zusätzlich existiert für jedes Tool ein öffentliches Repository mit jeweils zwei Pull Requests. Die Änderungen sind identisch, sodass sich die Ergebnisse direkt vergleichen lassen und ein differenziertes Bild der einzelnen Anwendungen entsteht.

Beobachtungen bei den Code Reviews

Nachdem die Grundlagen gelegt sind und alle Dienste unter denselben Bedingungen laufen, beginnt der spannendere Teil: Wie fühlen sich die Reviews tatsächlich an? Welche Art von Feedback erhalte ich, wie zuverlässig werden Fehler erkannt und wo zeigen sich Unterschiede?

Das Aufsetzen der Dienste verläuft unkompliziert. GitHub Copilot ist direkt einsatzbereit, da die Review-Funktion in GitHub integriert ist. Für CodeRabbit und Greptile genügt eine Verknüpfung mit dem Repository; ein Vorgang, der sich mit wenigen Klicks erledigen lässt.

Im praktischen Einsatz zeigt sich, dass KI-gestützte Reviews schnelles und unmittelbares Feedback liefern und damit ohne lange Wartezeiten nutzbar sind. Auffällig ist dabei:

- Viele der absichtlich eingebauten Fehler werden erkannt, allerdings nicht alle.

- Neben den Fehlerhinweisen erscheinen Anmerkungen zur Verbesserung der Codequalität, oft hilfreich, gelegentlich aber auch überflüssig oder ungenau.

- Teilweise erfassen die Tools Zusammenhänge zwischen Frontend und Backend, selbst wenn Änderungen nur in einem Bereich stattfinden.

- Hinweise zur allgemeinen Codestruktur gibt es eher selten.

- Völlig unpassende oder grobe Fehlvorschläge gibt es nicht.

- Die automatisch erzeugten Zusammenfassungen der geänderten Codestellen erleichtern den Überblick, enthalten aber manchmal kleine Ungenauigkeiten.

- Die Anzahl der Kommentare unterscheidet sich je nach Tool deutlich.

Um die Ergebnisse greifbarer zu machen, möchte ich einige konkrete Situationen aus den Tests hervorheben:

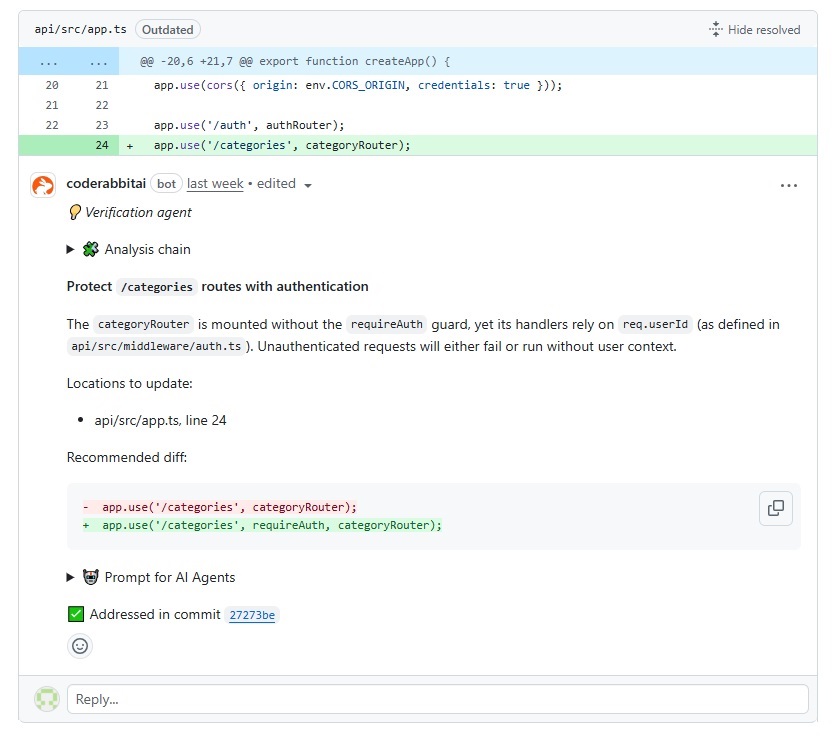

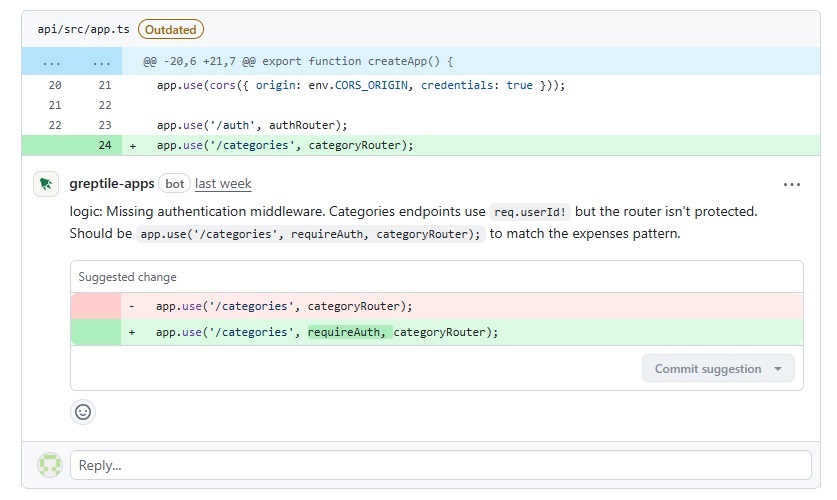

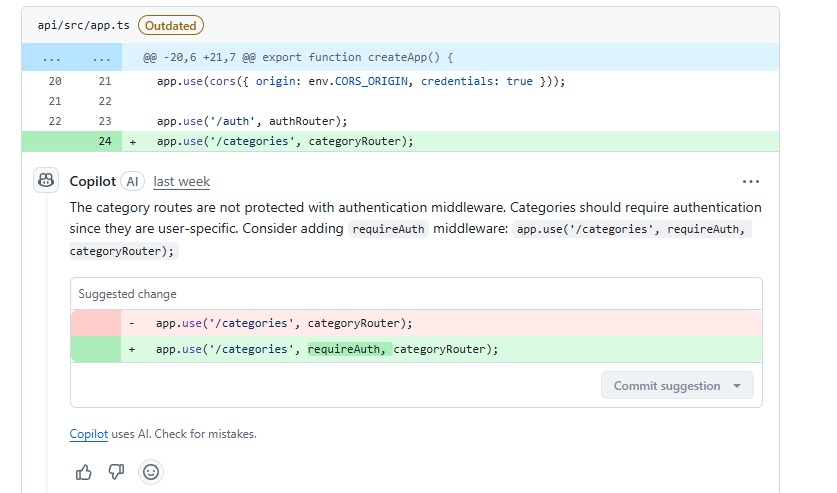

Ein fehlerhafter API-Aufruf im Frontend, dessen URL nicht mit dem Backend übereinstimmt, wird zuverlässig erkannt. Ebenso fällt ein fehlendes „await“ auf, und auch das Fehlen eines Checks zum Deaktivieren eines Buttons markieren die Tools. Dieser Hinweis verhindert unnötige API-Aufrufe. Alle Dienste weisen außerdem darauf hin, dass in einer neu hinzugefügten Route die Auth-Middleware fehlt und keine passende Response gesendet wird. Das ist ein klarer und kritischer Fehler.

Andere Probleme entdecken die Tools dagegen nicht durchgängig. Eine ungenutzte Backendabfrage im Frontend meldet nur Greptile. Ein Fehler im Filter der Abfrage von Expenses bleibt GitHub Copilot verborgen. Umgekehrt findet allein Copilot, wenn auch erst im zweiten Anlauf, dass beim Betätigen des Reset-Buttons nicht alle Filter zurückgesetzt werden.

Ungenutzter Code wird ebenfalls nicht konsequent erkannt. Einen überflüssigen Import entdeckt nur CodeRabbit, allerdings versteckt in den sogenannten „Nitpick“-Kommentaren. Auffällig ist zudem, dass keiner der Dienste auf die inkonsistente Benennung von Dateien eingeht. So bleibt unbemerkt, dass die neu angelegte Datei „categories.controller.ts“ nicht ins bestehende Namensschema passt.

Nützlich sind die zusätzlichen Hinweise zu Details wie der Nutzung des Date-Objekts im Frontend, einem verbesserten Error Handling oder einer präziseren Typisierung. Diese Anmerkungen liefern wertvolle Denkanstöße. Gleichzeitig erscheinen aber auch weniger sinnvolle Kommentare ohne erkennbaren Mehrwert, etwa wenn Copilot empfiehlt, einen simplen Vergleich durch einen Ternary Operator zu ersetzen.

Die automatisch erzeugten Zusammenfassungen der Anbieter funktionieren insgesamt gut und helfen, sich schneller in den Code hineinzuversetzen. Dennoch schleichen sich auch hier Fehler ein. So interpretieren CodeRabbit und Copilot eine verschobene Property fälschlicherweise als neu hinzugefügt.

Besonderheiten von CodeRabbit, Greptile und GitHub Copilot

Neben den allgemeinen Eindrücken lohnt sich ein genauerer Blick auf die Eigenheiten der einzelnen Dienste. Jedes Tool setzt eigene Schwerpunkte im Review-Prozess und geht dabei unterschiedlich mit Kommentaren, Zusammenfassungen und Zusatzinformationen um.

CodeRabbit

CodeRabbit liefert vergleichsweise viele Kommentare, darunter auch die sogenannten „Nitpick“-Hinweise. Diese enthalten kleinere Anmerkungen, die erst durch Aufklappen sichtbar werden. Die Idee: Details sollen nicht stören, aber bei Bedarf verfügbar sein. Das Konzept ist grundsätzlich sinnvoll, in der Praxis hatte ich jedoch den Eindruck, dass dort teilweise Punkte landeten, die wichtig genug gewesen wären, um nicht „versteckt“ zu werden. Dadurch besteht die Gefahr, dass man relevante Hinweise übersieht.

Darüber hinaus erweitert CodeRabbit die PR-Beschreibung um eine kurze Zusammenfassung. Zusätzlich gibt es einen detaillierten Walkthrough, ergänzt durch ein Sequenzdiagramm. Die Kommentare selbst sind meist ausführlich und enthalten häufig kleine Codeschnipsel, was das Feedback nachvollziehbar macht.

Abbildung 1: Beispielhafter CodeRabbit Kommentar

Greptile

Greptile ergänzt jedes Code Review um eine übersichtliche Zusammenfassung, die dabei hilft, schnell einen Überblick zu bekommen. Interessant ist außerdem der sogenannte Confidence Score, der eine Einschätzung liefert, wie sicher der Pull Request gemergt werden kann. Falls noch Probleme bestehen, werden diese kurz benannt. Das ist ein praktischer Ansatz. Allerdings kam es vor, dass Hinweise nur in dieser Zusammenfassung auftauchten und nicht als separater Kommentar. Dadurch besteht die Gefahr, dass solche Punkte übersehen werden oder schwer nachzuvollziehen sind.

Die Anzahl der Kommentare fiel bei Greptile insgesamt geringer aus als bei CodeRabbit. Sie waren meist kompakter formuliert, in vielen Fällen aber dennoch ausreichend klar.

Abbildung 2: Beispielhafter Greptile Kommentar

GitHub Copilot

Beim GitHub Copilot fällt auf, dass er am unaufdringlichsten wirkt. Die PR-Zusammenfassung ist kompakt gehalten und reicht in vielen Fällen aus, um sich schnell einen Überblick zu verschaffen. Auch die Anzahl der Kommentare ist deutlich geringer als bei den anderen beiden Diensten, und die Hinweise sind kürzer formuliert.

Eine auffällige Besonderheit zeigte sich jedoch: Nach Codeänderungen und erneutem Anstoßen des Reviews erschienen häufig neue Kommentare, die sich nicht auf die aktuellen Änderungen bezogen, sondern eigentlich schon früher hätten auftauchen sollen. Dadurch wurden wichtige Hinweise teilweise erst beim zweiten oder dritten Durchlauf sichtbar. Dieses Verhalten macht die Reviews schnell lückenhaft und lässt relevante Hinweise möglicherweise ganz ausfallen.

Abbildung 3: Beispielhafter GitHub Copilot Kommentar

Ein separater Blick auf den Datenschutz

Wer ein KI-Tool für Code Reviews einsetzen möchte, sollte sich im Vorfeld unbedingt mit den Angaben zum Datenschutz und zu den Sicherheitsmaßnahmen beschäftigen. Die folgenden Punkte geben einen ersten Überblick zu CodeRabbit [4], Greptile [5] und GitHub Copilot [6].

CodeRabbit

- Code wird ausschließlich für Reviews in einer isolierten Umgebung verarbeitet und nicht dauerhaft gespeichert.

- LLM-Provider erhalten nur Code-Diffs und kontextuelle Informationen.

- Proprietärer Code fließt nicht in das Training von Sprachmodellen ein.

- SOC 2 Type II zertifiziert (externe Prüfung von Sicherheits- und Datenschutzmaßnahmen)

Greptile

- Quellcode wird nach Abschluss des Reviews gelöscht.

- Vektor-Embeddings aus Dateipfaden, Dokumentation oder KI-generierten Kommentaren können gespeichert werden.

- Proprietärer Code wird nicht zum Training von Sprachmodellen genutzt.

- SOC 2 Type II zertifiziert (externe Prüfung von Sicherheits- und Datenschutzmaßnahmen).

- Self-Hosting möglich, Betrieb in eigener Infrastruktur.

GitHub Copilot

- Proprietärer Code wird nicht ohne Zustimmung für das Training öffentlich zugänglicher Modelle genutzt.

- In den Einstellungen lässt sich festlegen, ob Daten wie Vorschläge oder Prompts für Modellverbesserungen verwendet werden dürfen.

- Copilot Business und Copilot Enterprise sind unter anderem SOC 2 Type II und ISO/IEC 27001 zertifiziert.

Auch wenn die drei Anbieter ihre Maßnahmen klar benennen, empfiehlt es sich, die aktuellen Datenschutzrichtlinien stets im Detail zu prüfen, bevor die Tools in echten Projekten eingesetzt werden.

Fazit

Mein Fazit zu Code Reviews mit KI-Tools fällt gemischt aus. Einerseits ersetzen sie menschliche Reviews nicht. Zu häufig treten Fehler, Unvorhersehbarkeiten oder Inkonsistenzen auf, und auch der Blick auf ein Projekt als Ganzes gelingt ihnen nicht in der Tiefe, wie es erfahrene Entwicklerinnen und Entwickler leisten können. Andererseits erkennen die Tools viele Fehler zuverlässig und liefern Verbesserungsvorschläge, die Pull Requests sinnvoll ergänzen.

Besonders als erste Prüfung, bevor ein Teammitglied den Code betrachtet, können sie Zeit sparen. Für Solo-Entwicklerinnen und -Entwickler sind sie ebenfalls wertvoll, da sie Hinweise zur Codequalität geben und gerade beim Arbeiten mit neuen Technologien eine hilfreiche Unterstützung darstellen.

Ein weiterer Aspekt ist die Preisfrage. Wären die Tools kostenlos verfügbar, würde ich sie in jedem Fall empfehlen, da sie sich als nützliche Ergänzung im Alltag bewährt haben. Bei kostenpflichtigen Angeboten lohnt es sich jedoch, genau abzuwägen, ob der Nutzen den Preis rechtfertigt. Eine belastbare Einschätzung ist ohnehin erst durch den dauerhaften Einsatz in realistischen Projekten möglich.

Ebenso wichtig bleibt das Thema Datenschutz. Gerade für Unternehmen oder Teams mit sensiblen Codebasen empfiehlt sich ein genauer Blick auf die Richtlinien der Anbieter. Diese sollten immer im Detail geprüft und mit den eigenen Anforderungen abgeglichen werden.

Einen klaren Sieger möchte ich nicht benennen. Unterschiedliche Codebasen oder Projekttypen können zu unterschiedlichen Ergebnissen führen. In meinem ersten Eindruck wirkten CodeRabbit und Greptile als spezialisierte Review-Tools etwas zuverlässiger und hilfreicher. Gleichzeitig punktet GitHub Copilot mit einer niedrigen Einstiegshürde, da die Review-Funktion bereits in der bestehenden Mitgliedschaft enthalten ist. Für viele dürfte das der einfachste Weg sein, erste Erfahrungen mit KI-Code-Reviews zu sammeln.

Hinweise:

[1] CodeRabbit

[2] Greptile

[3] GitHub Copilot

[4] Trust Center und FAQ CodeRabitt

[5] Greptile Security

[6] Manage Policies und Trust Center GitHub Copilot

Hier finden Sie einen Beitrag über die Entwicklung einer iOS-App mit generativer KI.

Her finden Sie einen Beitrag über Unit-Tests mit KI.

Und hier finden Sie weitere Informationen zum Thema Code Review.

Wollen Sie als Meinungsmacherin oder Kommunikator über das Thema diskutieren? Dann teilen Sie den Beitrag gerne in Ihrem Netzwerk. Und falls Sie sich für weitere Tipps aus der Praxis interessieren, dann abonnieren Sie unseren beliebten Newsletter.

Christoph Bohne

Christoph Bohne arbeitet als Softwareentwickler bei t2informatik.

Als Quereinsteiger hat er auf seinem ungewöhnlichen Weg in die IT entdeckt, wie wichtig Neugier und Offenheit für Neues sind. Mit Freude lernt und probiert er immer wieder Neues aus. Seine besten Ideen kommen ihm oft beim Spaziergang mit seinem Hund.

Im t2informatik Blog veröffentlichen wir Beträge für Menschen in Organisationen. Für diese Menschen entwickeln und modernisieren wir Software. Pragmatisch. ✔️ Persönlich. ✔️ Professionell. ✔️ Ein Klick hier und Sie erfahren mehr.